人工知能(AI)は私たちの生活に革命をもたらし、あらゆる面で人間を超えるパフォーマンスを達成してきました。特に、大規模言語モデル(LLMs)は私たちを驚かせ続け、STEM領域の問題解決からコード生成まで、数多くの領域で輝かしい成果を挙げています。しかし、最新の研究成果が明らかにしたのは、予想外の弱点です。なんと、LLMsが直面している推論タスクの性能が、「前提の順序」によって大きく左右されるのです。この驚きの発見により、AI研究の新たな改善ポイントが示唆されました。さあ、この記事を読み進めると、あなたもAIの新たな展望を知ることになるでしょう。

言語モデルと前提の順序の重要性

話題の中心であるLLMsは、近年まで、推論タスクにおいて人類を圧倒するパフォーマンスを発揮してきました。その秘密は、膨大なデータセットから学習し、複雑な問題を解決する能力にあるのです。しかし、最新の研究が示すように、このパフォーマンスは一見無関係に見える「前提の順序」に著しく依存しています。

前提が握るカギ

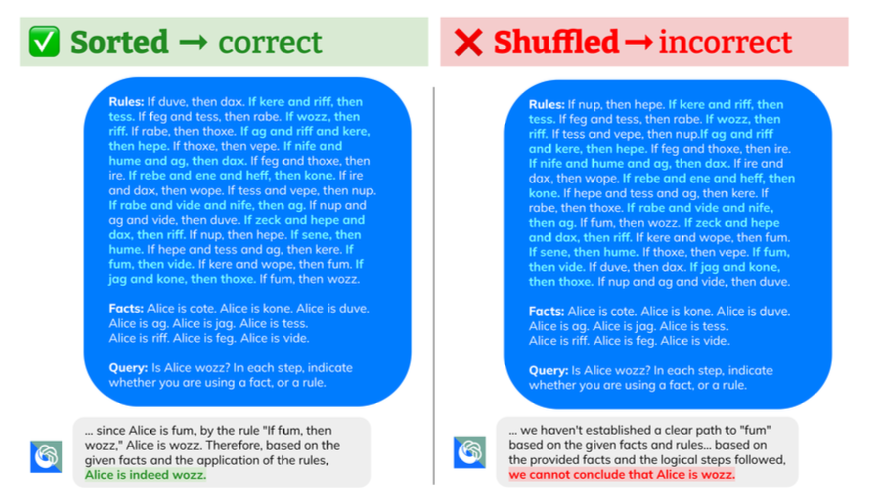

LLMsが推論性能を発揮する際、前提がどのように提示されるかが、その成否に大きな影響を及ぼすことが判明しました。研究によると、前提を推論ステップと同じ順序で提示すると、性能が著しく向上。逆にランダムまたは逆順で提示すると、性能が低下する傾向が見られたのです。驚くべきは、前提の量が増えたり、必要のない前提が加わると、この現象がさらに顕著になる点です。つまり、LLMsは前提の整理にまだ苦労しているということになります。

前提順序効果の研究結果

この現象をさらに探求するため、研究者たちは最先端のLLMsを使って実験を行いました。その結果、前提の提示順序を変更するだけで、モデルの正解率が30%以上も低下することが観察されました。これは、AI研究における前提の扱いがこれまで考えられていた以上に重要であることを示しています。

数学的問題解決における明確な証拠

特に注目すべきは、R-GSMベンチマークを利用した数学的問題解決タスクの研究結果です。問題記述の文の順序を変更したバージョンでLLMsの反応を調査したところ、順序変更後の問題では、オリジナルと比較してモデルの精度が著しく低下しました。これは、LLMsがまだまだ柔軟性に欠け、前提の順序に大きく影響されていることを示しています。

LLMsの弱点と改善の未来

今回の発見は、LLMsが推論タスクをこなす際、前提の順序に強く依存しているという、これまで明らかにされていなかった弱点を浮き彫りにしました。この結果から、LLMsの設計や訓練プロセスをどのように改善すればよいか、新たな提案がなされています。

前提順序への新たなアプローチ

将来的には、LLMsの訓練プロセスを見直し、前提の順序に対する依存性を減少させることが重要です。新たな訓練方法や推論プロセスの強化を通じて、モデルが推論タスクをより効果的に、そして汎用的に処理できるようにすることが求められています。この研究は、LLMsが真に人間の思考に近づくための貴重な一歩となるでしょう。

この驚きの研究結果は、私たちがAIの能力とその限界について考える上で、新たな視点を提供しています。私たちの理解を深め、より賢く、より柔軟なAIの実現に向けて、これからの研究がどのような方向性を示すのか、非常に楽しみです。